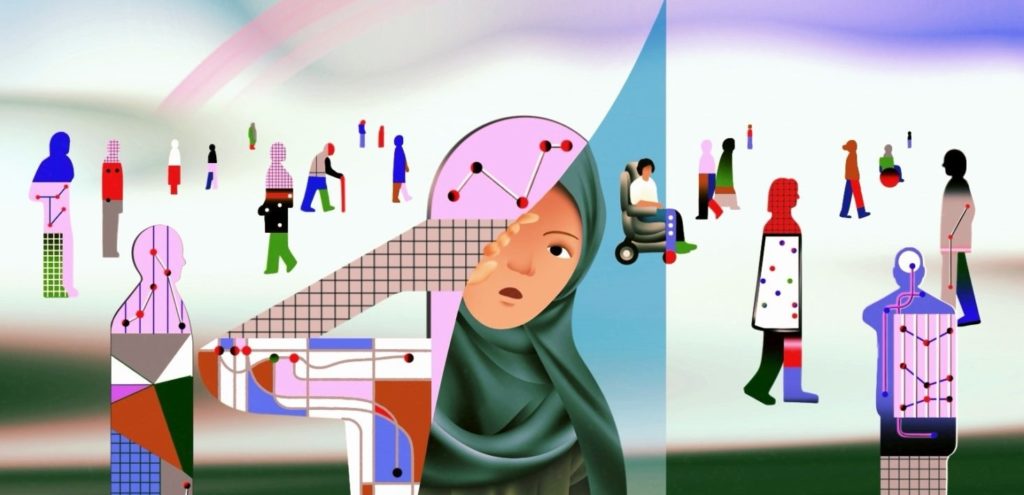

Avec l’entrée en vigueur des dispositions relatives à la reconnaissance faciale, les préoccupations majeures liées aux risques de discriminations associées à cette technologie doivent être rappelées. La partie de l’AI Act attaquée s’appuie sur les pratiques dorénavant proscrites autour de l’utilisation de l’IA, en raison de réels risques fondés pour les droits fondamentaux des personnes. Or, les contours de ces dispositions sont très opaques et offrent ainsi le champ à des dérives discriminatoires.

Profilage ethnique et fichage de la population

Les inquiétudes quant au fichage ethnique, de certains groupes de la population, et la surveillance de groupes historiquement marginalisés et criminalisés, sont réelles et fondées. Ces inquiétudes trouvent leur source dans la proposition de loi déposée le 17 décembre 2024 par le ministre de la Justice Paul Van Tigchelt. Proposition qui << vise à autoriser l’utilisation de systèmes d’identification biométrique à distance en temps réel dans des espaces accessibles au public à des fins répressives >>. (Doc 56 0601/001 ; Chambre des représentants de Belgique ). Dès lors, des erreurs graves et dérives peuvent survenir : des arrestations injustifiées, des exclusions ou des discriminations systématiques. Par ailleurs, l’utilisation de cette technologie implique une surveillance permanente, ce qui revient à donner aux autorités le pouvoir d’identifier l’intégralité de sa population dans l’espace public, entraînant de fait une atteinte à la vie privée et au droit à l’anonymat des citoyen.nes. Les possibilités de se rassembler, lors des manifestations le cas échéant, et la liberté d’expression se voient donc considérablement restreintes, voire totalement inhibées.

Il est de même nécessaire de s’interroger sur les conséquences qu’auraient ces décisions et cette technologie dans le contexte d’un État ‘’policier’’, alors que nous assistons de plus en plus à la montée de l’extrême droite dans notre pays.

La boîte de pandore à toutes les dérives.

L’utilisation de cette technologie comporte des risques accrus sur les questions de stockage des données. Les risques de piratages informatiques visant ces données biométriques sont importants, au regard de l’importance et de la sensibilité de ces dites données. En outre, l’actualité belge en la matière, a maintes fois montré que les données récoltées par les autorités publiques n’étaient pas et ne sont pas à l’abri des piratages. Ce qui ouvre la porte à des manipulations complètement incontrôlables.

Sur les risques de discriminations par exemple, plusieurs rapports (à l’instar de l’analyse de Jean François Raskin, professeur et chercheur au département des sciences informatiques de l’ULB)[1] montrent que cette technologie reproduit les discriminations sexistes ou racistes, elles-mêmes induites par les conceptions sociales dominantes et des institutions qui les vendent et les utilisent.

En tant que mouvement antiraciste et de vigilance citoyenne, luttant contre toutes les formes de discrimination, il est des missions du Mrax d’attirer l’attention des citoyens sur l’utilisation d’une technologie qui aura pour conséquences d’exacerber les inégalités sociales et la régression des droits fondamentaux. Il ne s’agit pas d’un pas en avant, mais plutôt d’un retour vers des pratiques que l’on pensait révolues. Il s’agit d’un boulevard vers une sorte de « crédit social » à l’instar de certains régimes à travers la planète.

Crédit visuel (graphisme) : Amnesty international

[1] https://prisme.ulb.be/tous-les-numeros/ete-2023/discrimination-et-prejuges-une-ia